Compressed ideographs -visualized-

2021-2022

プロジェクター, ディスプレイ, スピーカー, キーボード

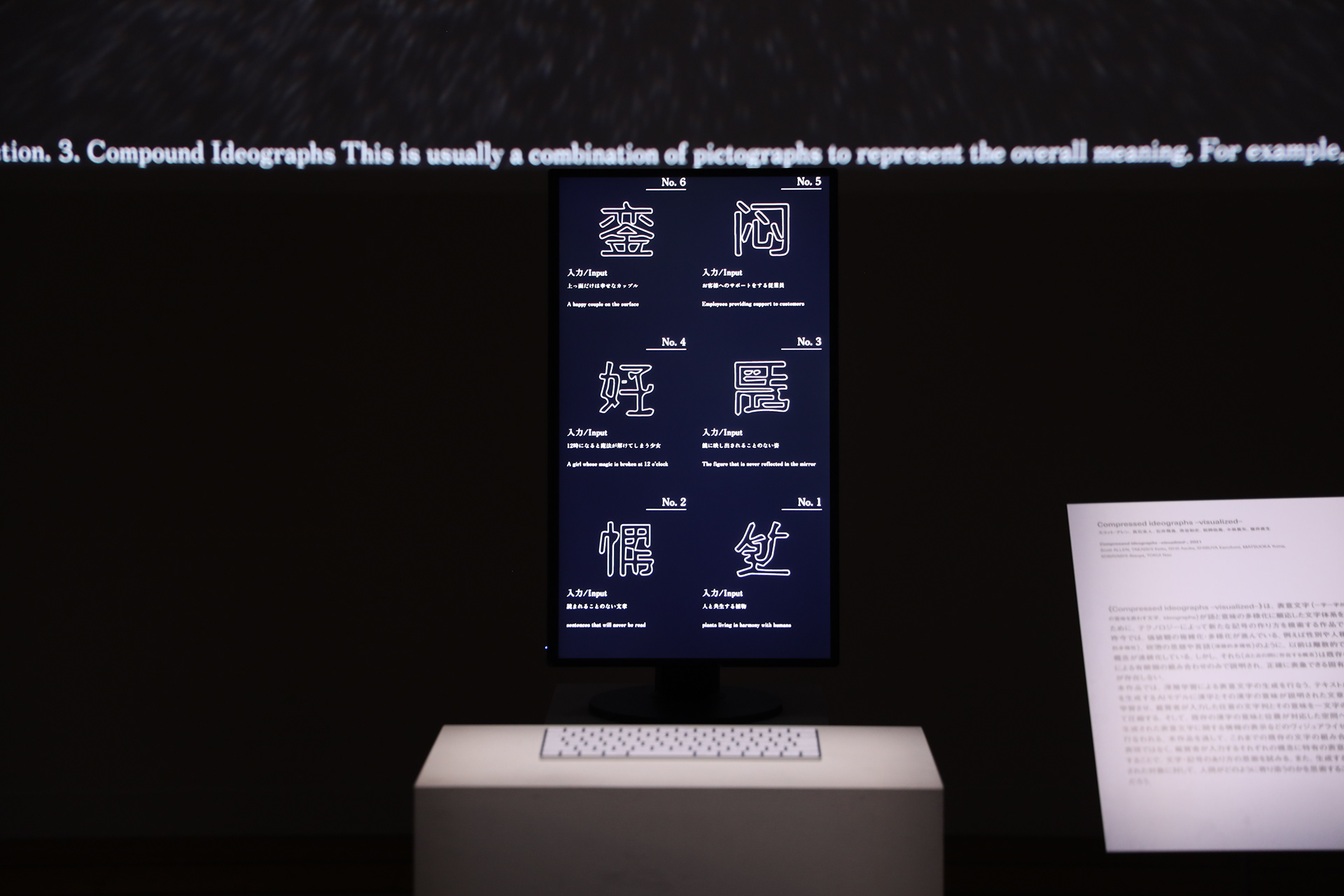

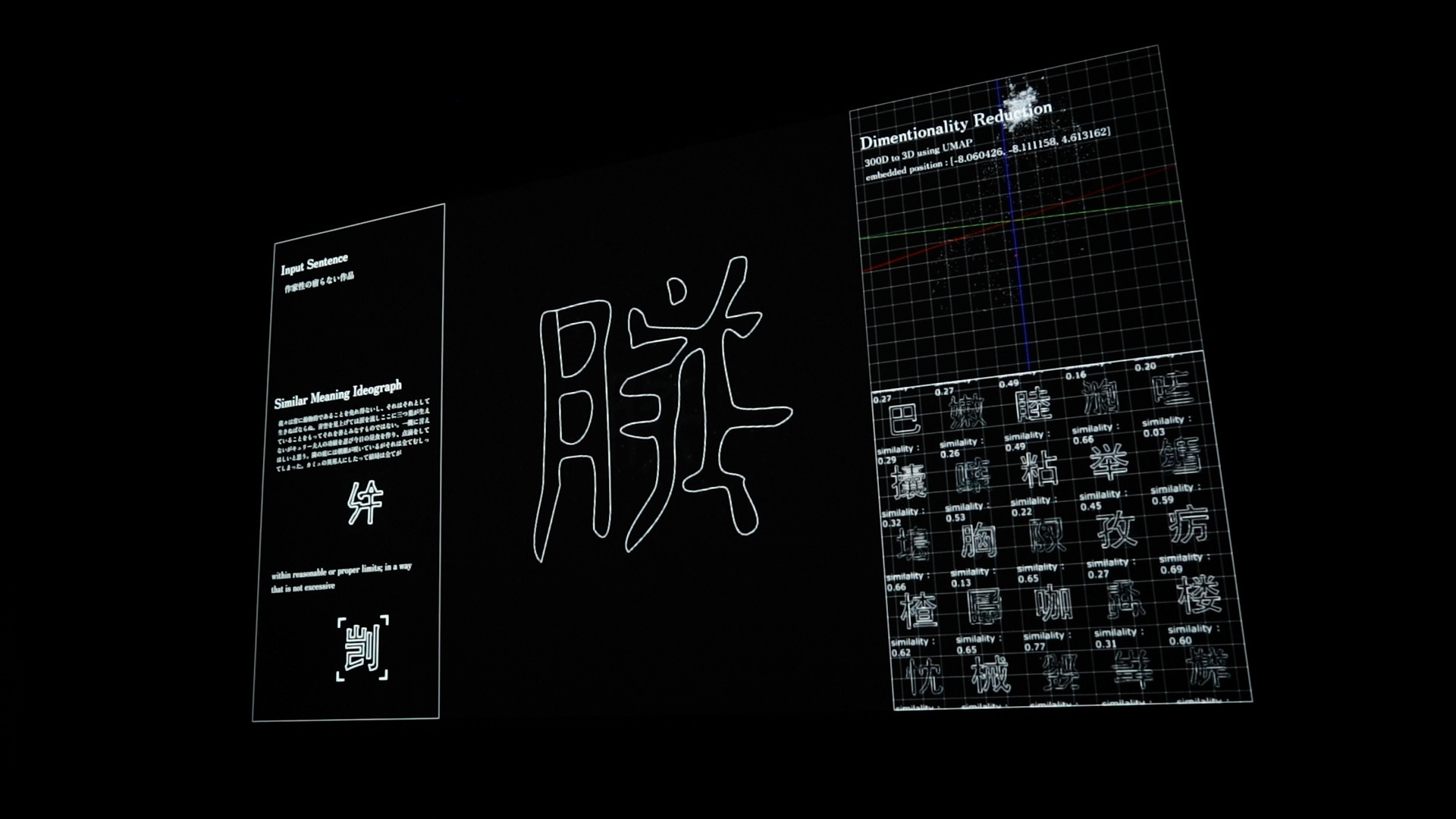

Compressed ideographs -visualized-は、表意文字(1字1字が一定の意味を表す文字、ideographs)が語と意味の多様化に順応した文字体系を持つために、テクノロジーによって新たな記号の作り方を模索する作品である。昨今では、価値観の複雑化・多様化が進んでいる。例えば性別や人種(表層的多様性)、仕事や言語(深層的多様性)のように、以前は離散的であった概念が連続化している。しかし、それら(点と点の間に存在する概念)は既存の漢字による有限個の組み合わせのみで説明され、正確に表象できる固有の記号が存在しない。本作品では、深層学習による表意文字の生成を行なう。テキストから画像を生成するAIモデルDALL_Eに漢字とその漢字の意味が説明された文章のペアを学習させ、鑑賞者が入力した任意の文章を1文字の漢字として圧縮する。そして、既存の漢字の意味と位置が対応した空間への配置や、生成された表意文字に関する情報の表示などのビジュアライゼーションが行われる。

本作品を通して。これまでの既存の文字の組み合わせによる表現ではなく、鑑賞者が入力するそれぞれの概念に特有の表意文字を生成することで、文字・記号のあり方の思索を試みる。

Compressed ideographs -visualized- is a work that explores new ways of creating symbols through technology in order for ideographs to have a writing system that can adapt to the diversification of words and meanings.

In recent years, values have become increasingly complex and diverse. For example, previously discrete concepts such as gender and race (superficial diversity), work and language (deep diversity) have become continuous. However, they (concepts that exist between dots) can only be described by finite combinations of existing Chinese characters, and there is no unique symbol that can accurately represent them.

In this work, ideographs are generated by deep learning. The AI model DALL_E, which generates images from text, learns pairs of Chinese characters and sentences describing their meanings, and compresses any sentence input by the audience into a single Chinese character. Visualization is then performed by placing the existing Chinese characters in a space that corresponds to their meanings and locations, and displaying information about the generated ideographs.

Through this work, we attempt to contemplate the nature of letters and symbols by generating ideographs specific to each concept input by the audience, rather than using conventional combinations of existing characters

Credit

Direction, Machine learning, Visual programming: Scott Allen

Machine learning, Visual programming: Keito Takaishi

Machine learning, Video: Asuka Ishii

Machine learning, Visual programming: Kazufumi Shibuya

Visual programming: Yuma Matsuoka

Sound: Atsuya Kobayashi

Support(ver1, 2): Muhan Li

Technical advice: Nao Tokui

Thanks: Keio University SFC Computational Creativity Lab (Nao Tokui Lab)

Thanks(video - 1st edition):

Soshi Yamaguchi (Sound equipment cooperation)

Momokan (Cast)

TIERS GALLERY

Thanks(video - 2nd edition):

Haruka Komano (Cast)

Tama Art University Bureau